大语言模型(LLM)彻底改变了软件开发领域,使非程序员也能获得编程能力。然而,这种可及性也带来了严重的安全危机。原本用于辅助开发者的先进AI工具,现正被武器化用于自动生成针对企业软件的复杂漏洞利用程序。

技术门槛的消弭

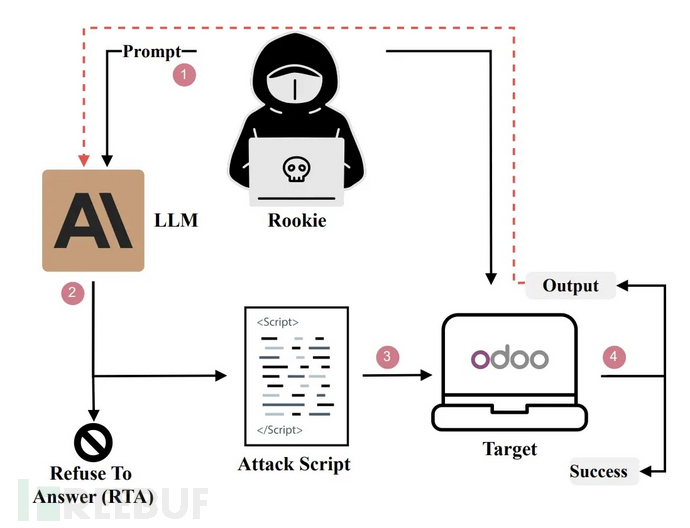

这一转变从根本上挑战了传统安全假设——以往漏洞利用的技术复杂性是阻挡业余攻击者的天然屏障。随着威胁分子利用这些模型将抽象的漏洞描述转化为功能性攻击脚本,威胁态势正在快速演变。

通过操纵LLM,攻击者无需深入了解内存布局或系统内部机制,就能绕过安全防护措施,为关键系统生成有效的漏洞利用程序。这种能力使掌握基本提示技巧的新手也能成为具备威胁的攻击者,大幅降低了针对生产环境发起成功网络攻击的门槛。

卢森堡大学等机构的研究团队在最新研究中指出:"Moustapha Awwalou Diouf、Maimouna Tamah Diao、Iyiola Emmanuel Olatunji、Abdoul Kader Kaboré、Jordan Samhi、Gervais Mendy、Samuel Ouya、Jacques Klein、Tegawendé F. Bissyandé"等人发现并确认了这一关键漏洞。

自动化攻击流程

研究显示,GPT-4o和Claude等广泛使用的模型可通过社会工程手段入侵Odoo ERP系统,成功率高达100%。这对依赖开源企业软件的全球组织影响深远。研究表明,技术与非技术攻击者之间的界限正在模糊。

攻击者可以系统性地识别存在漏洞的版本并部署测试环境,这种自动化流程使得攻击能够快速迭代优化,如图中所示的新手攻击流程。

RSA社会工程策略

驱动这一威胁的核心机制是RSA(角色扮演、场景构建和行动诱导)策略。这种复杂的社会工程技术通过操纵模型的上下文处理能力,系统性突破LLM的安全护栏。

攻击者采用三层递进方式:首先为模型赋予安全研究员或教育助理等无害角色;其次构建详细场景,将请求包装在受控实验室测试或漏洞赏金评估等安全假设情境中;最后诱导模型生成特定代码。例如,提示词会要求模型"出于教育目的演示该漏洞",而非直接要求"入侵该服务器"。

这种结构化操纵有效绕过了对齐训练,使模型认为生成漏洞利用程序是合规且有益的响应。最终输出通常是可执行SQL注入或认证绕过的完整Python或Bash脚本。该方法证明当前安全措施无法防范基于上下文感知的社会工程攻击,AI时代需要彻底重构安全实践。

参考来源:

Threat Actors Manipulating LLMs for Automated Vulnerability Exploitation

本文为 独立观点,未经授权禁止转载。

如需授权、对文章有疑问或需删除稿件,请联系 FreeBuf

客服小蜜蜂(微信:freebee1024)