Nelle aziende si annida un ladro silenzioso: la Shadow AI, l’uso non autorizzato di strumenti di intelligenza artificiale da parte dei dipendenti. Non è paranoia da cybersecurity, ma una bomba a orologeria che mescola tecnologia, comportamento umano e policy aziendale. La vera sfida per i leader non è proibire questi strumenti, ma governarli, trasformando un rischio invisibile in un vantaggio competitivo trasparente e condiviso prima che sia troppo tardi.

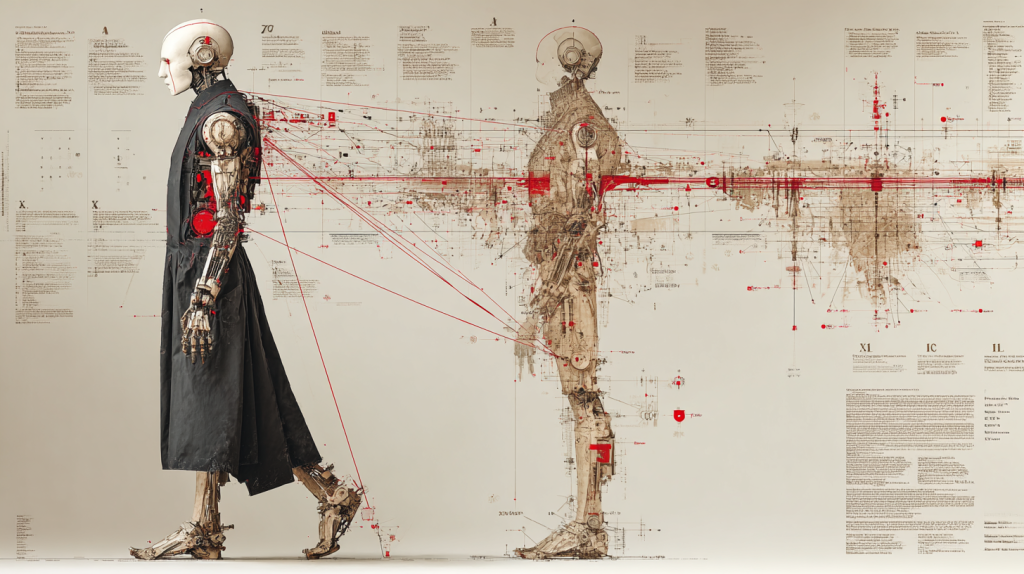

C’è un fantasma che si aggira per le nostre aziende. Non forza porte, non scassina casseforti, ma sottrae il bene oggi più prezioso: la proprietà intellettuale. E la beffa è che a spalancargli le porte sono i nostri stessi dipendenti, ogni giorno, click dopo click.

Questo fenomeno ha un nome preciso: Shadow AI, l’intelligenza artificiale “ombra”. È un termine, come evidenziato anche dalla Cloud Security Alliance in un’analisi puntuale, che descrive l’utilizzo di strumenti di AI da parte dei lavoratori senza la supervisione, l’approvazione o persino la conoscenza dei dipartimenti IT e della dirigenza. Non è un concetto inedito, ma la diretta evoluzione dello Shadow IT – ricordate il “bring your own device”? – potenziato però da una scala e una facilità d’accesso senza precedenti. Basta un browser e una carta di credito.

È una dinamica che mette a nudo uno dei bias cognitivi più classici: il beneficio immediato percepito schiaccia la paura di un rischio futuro e astratto. L’utilità di riassumere un report in 30 secondi è più forte della remota possibilità di una sanzione aziendale.

Un Fenomeno Sottovalutato, ma Misurabile

Non stiamo parlando di un’ipotesi. I numeri sono chiari e allarmanti. Uno studio di Software AG rivela che quasi la metà dei lavoratori ammette di usare l’AI per conto proprio e continuerebbe a farlo anche a fronte di un divieto esplicito dell’azienda.

Un altro rapporto, firmato da Cyberhaven, è ancora più esplicito: l’uso di tool come ChatGPT e Gemini sul posto di lavoro è esploso, e con esso la quantità di dati sensibili e riservati che vi finisce dentro. Non parliamo di appunti personali, ma del cuore pulsante delle aziende: bozze di email strategiche, codice sorgente, dati di ricerca e sviluppo, documenti legali, piani di marketing e, ovviamente, informazioni sui dipendenti. Stiamo, di fatto, regalando i nostri asset più preziosi per allenare i modelli di qualcun altro.

Non Solo Fuga di Dati: I Rischi Sistemici dell’IA Ombra

Limitare il problema alla sicurezza o alla fuga di dati sarebbe riduttivo. La Shadow AI è un’idra dalle molte teste, che erode l’azienda su più fronti contemporaneamente.

Il primo, e più ovvio, è la compliance. Con normative come il GDPR e l’imminente AI Act, lasciare che i dipendenti usino strumenti non approvati espone l’azienda a sanzioni pesantissime. L’ignoranza del management, sia chiaro, non costituisce una scusante valida in un’aula di tribunale.

Il secondo è un’erosione profonda della governance. Se ogni team, o addirittura ogni singolo individuo, usa strumenti diversi per analisi, reportistica o sviluppo, l’azienda perde ogni visione d’insieme. Le decisioni non vengono più prese sulla base di dati e processi validati, ma affidate a “scatole nere” opache, con tutti i rischi che ne conseguono: bias, allucinazioni, errori grossolani e output di pessima qualità. È un caos operativo mascherato da un’illusoria efficienza individuale.

Infine, si crea un enorme debito tecnologico e di conoscenza. Invece di costruire un’infrastruttura AI interna, coerente e strategica, si finisce per avere una costellazione di micro-servizi incontrollabili, spesso pagati con carte di credito personali. Peggio ancora, potremmo parlare di “inquinamento della conoscenza”: un dipendente che usa un’AI per generare del codice e lo copia-incolla nel repository aziendale potrebbe importare, a nostra insaputa, vulnerabilità di sicurezza o violazioni di licenze software restrittive.

Un Sintomo, non la Malattia: Perché Proibire è Inutile

La Shadow AI è soprattutto un sintomo. È la manifestazione di una frattura profonda tra la velocità dell’innovazione che pretendiamo dai nostri collaboratori e la cronica lentezza con cui le organizzazioni si adattano. Chiediamo agilità, ma offriamo burocrazia. Il dipendente, lasciato a sé stesso, sceglie la via più comoda ed efficace.

Ecco perché il vecchio modello di governance, il command and control che proibisce tutto ciò che non riesce a gestire, è destinato a fallire. Le policy scritte e calate dall’alto diventano muri di carta che la spinta all’efficienza individuale aggira con facilità. Il fenomeno della Shadow AI è uno stress test non per la tecnologia, ma per la leadership. Obbliga i manager a smettere di riempirsi la bocca con la parola “innovazione” e a costruire una strategia concreta.

La Strategia del Leader: Governare l’Innovazione, non Soffocarla

La risposta non può essere bloccare ChatGPT con un firewall. La soluzione è un mix strategico di governance, fiducia e formazione. Si regge su tre pilastri fondamentali:

- Policy Chiare e Motivate: Non basta dire “no”. Bisogna spiegare cosa si può fare, cosa no, con quali strumenti e, soprattutto, perché. Le regole devono essere contestualizzate per essere rispettate.

- Strumenti Validi e Approvati: Se si vieta l’uso di un tool esterno, bisogna fornire un’alternativa interna che sia altrettanto valida, sicura e funzionale. Lo strumento ufficiale, per definizione, deve essere competitivo con quello “ombra”, altrimenti la battaglia è persa in partenza.

- Formazione Ossessiva: È necessario creare una cultura della consapevolezza, quella che l’AI Act chiama AI Literacy. Bisogna formare le persone a riconoscere i rischi, a usare gli strumenti in modo responsabile e a comprendere l’impatto delle loro azioni sull’intera organizzazione. La consapevolezza è un’arma più potente della paura.

La vera sfida per un leader oggi non è impedire l’uso dell’intelligenza artificiale. È una battaglia persa. La sfida è governarla, trasformare il rischio invisibile della Shadow AI in un vantaggio competitivo trasparente e condiviso.

Perché il pericolo, in fondo, non è che i vostri dipendenti usino l’AI. Lo faranno, punto. Il vero pericolo è che la usino senza dirvelo, contro gli interessi dell’azienda, e che voi ve ne accorgiate solo quando sarà troppo tardi.