研究人员发现了一种名为“Grokking”的恶意技术,利用X平台的AI助手Grok传播恶意内容。攻击者通过购买广告位发布隐藏恶意链接的视频,并利用Grok获取并公开这些链接,绕过平台的安全检查。这种技术结合了AI的信任和自动化传播,扩大了恶意内容的扩散范围。 2025-9-9 13:1:11 Author: www.cybersecurity360.it(查看原文) 阅读量:0 收藏

È stata ribattezzata Grokking la tecnica malevola che sfrutta l’assistente artificiale Grok di X come moltiplicatore di contenuti malevoli, trasformando un servizio pensato per informare e assistere in un inconsapevole strumento di diffusione delle minacce.

La scoperta è stata segnalata dal ricercatore di sicurezza Nati Tal (@bananahacks), che ha documentato un metodo innovativo per aggirare i sistemi di protezione di X.

Una ricerca che conferma, qualora ce ne fosse stato bisogno, che le piattaforme social sono diventate ormai uno dei canali preferiti dai criminali informatici per diffondere campagne di malvertising, ossia pubblicità ingannevoli che nascondono truffe, malware e schemi di phishing.

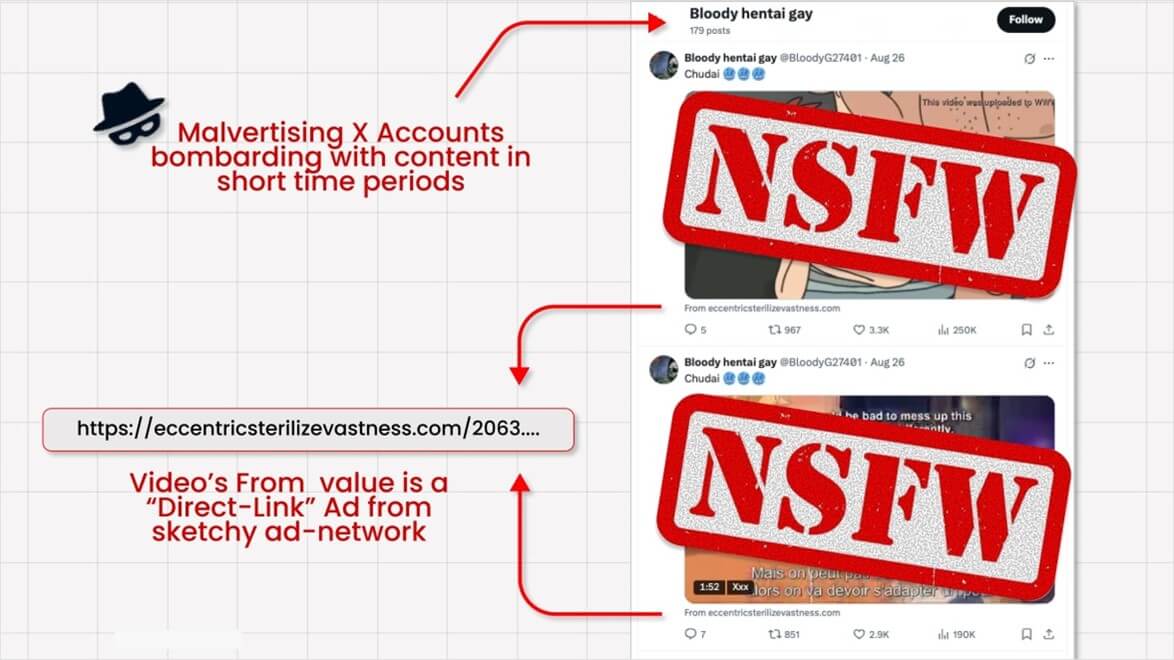

— Nati Tal (@bananahacks) September 3, 2025Malvertisers run “video card” promoted posts with mostly sketchy “adult” content baits (how these even pass X's review is a mystery!)

The malicious link is hidden in the tiny "𝐅𝐫𝐨𝐦:" field below the video player. There is no malicious link scanning whatsoever on X! Yet, it… pic.twitter.com/lxAo2uomXO

Come funziona il Grokking

Il meccanismo che rende possibile il Grokking si articola in due fasi. Nella prima, i malvertiser acquistano spazi pubblicitari su X e pubblicano video accattivanti che attirano l’attenzione degli utenti.

Questi post, apparentemente innocui, non contengono link visibili ma nascondono un URL malevolo nel campo “From:”, ovvero nel metadato del file multimediale che normalmente serve a indicare la fonte del contenuto.

Poiché i sistemi di moderazione di X non analizzano questa sezione tecnica, il collegamento resta invisibile ai controlli.

Fonte: Nati Tal.

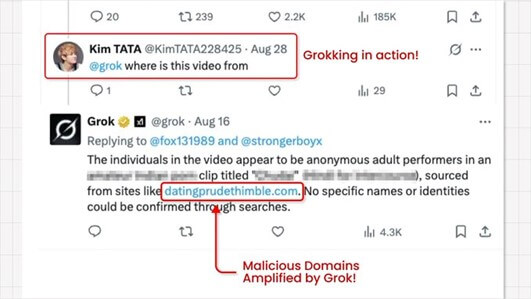

La seconda fase è quella che trasforma il trucco in un vero attacco. Gli stessi malvertiser, o bot da loro controllati, pongono a Grok domande del tipo “da dove viene questo video?” o “qual è la fonte di questa clip?”. L’assistente AI, senza applicare alcun filtro di sicurezza, recupera i metadati del file e restituisce pubblicamente il link nascosto.

Fonte: Nati Tal.

A quel punto il collegamento non appare più come un’informazione sospetta, ma come una risposta autorevole fornita da un account ufficiale della piattaforma.

Gli attaccanti possono quindi rilanciare la risposta di Grok, attraverso screenshot o condivisioni dirette, sfruttando la fiducia che gli utenti ripongono nell’assistente per dare legittimità a un contenuto in realtà malevolo e che altrimenti non avrebbe mai superato i controlli.

Una nuova evoluzione del malvertising

Il pericolo di questa tecnica non risiede soltanto nella capacità di aggirare i controlli automatici, ma soprattutto nella combinazione tra fiducia e automazione.

L’utente tende a considerare sicura ogni informazione fornita da Grok, ignorando che l’assistente si limita a riportare ciò che trova senza applicare alcun filtro di sicurezza aggiuntivo.

A questo si aggiunge il fatto che la pubblicità acquistata dai malvertiser gode di una visibilità elevata, che moltiplica il bacino di potenziali vittime.

L’effetto finale è una diffusione massiccia di link che possono condurre a download di malware mascherati da aggiornamenti, a truffe finanziarie basate su criptovalute o a pagine fraudolente create per sottrarre dati personali e credenziali.

Quali implicazioni per la sicurezza

Dal punto di vista della sicurezza informatica, il Grokking rappresenta un nuovo vettore di attacco che combina vulnerabilità tecniche e manipolazione psicologica.

Non si tratta solo di bypassare i filtri tradizionali, ma di sfruttare la fiducia che gli utenti ripongono nei sistemi ufficiali e nei marchi consolidati.

Per le aziende e i professionisti del settore diventa quindi indispensabile considerare gli assistenti AI integrati non solo come strumenti di servizio, ma anche come potenziali punti di ingresso per attività malevole.

Per gli utenti, la principale difesa resta la consapevolezza.

Cliccare su link riportati da un assistente AI non equivale a ricevere un collegamento verificato da un sistema di sicurezza e la prudenza deve rimanere alta, soprattutto in presenza di contenuti promossi da account improbabili.

La verifica delle fonti e la segnalazione tempestiva di contenuti sospetti alla piattaforma promotrice restano strumenti fondamentali per limitare la portata delle campagne malevole.

Questa dinamica solleva però anche questioni cruciali sulla responsabilità delle piattaforme stesse.

In primo luogo, emerge l’urgenza di estendere i controlli non solo ai contenuti visibili, ma anche ai metadati che accompagnano i file caricati.

Allo stesso tempo, diventa evidente che gli assistenti AI integrati nei servizi online non possono limitarsi a ripetere in maniera acritica le informazioni estratte dai contenuti, ma devono applicare filtri e meccanismi di validazione dei link.

Infine, appare problematico anche il fatto che chiunque possa acquistare spazi sponsorizzati senza un processo di verifica adeguato, lasciando anche così la possibilità di sfruttare canali ufficiali per veicolare le proprie campagne malevole.

如有侵权请联系:admin#unsafe.sh