Guerre di Rete - una newsletter di notizie cyberdi Carola FredianiN.175 - 10 dicembre 2023La newslet 2023-12-10 21:1:34 Author: guerredirete.substack.com(查看原文) 阅读量:22 收藏

Guerre di Rete - una newsletter di notizie cyber

di Carola Frediani

N.175 - 10 dicembre 2023La newsletter va in vacanza di Natale. Ci risentiamo a gennaio e Buone Feste!!

(Nel mentre seguite il sito Guerre di Rete. Mentre ci vediamo a Game of Tech, all’università di Napoli Federico II, evento di cui Guerre di Rete è media partner)

In questo numero:

- Scarica il nostro ebook Generazione AI

- Come è andata con l’AI Act

- Messenger cifrato

- Gemini

- Il lato oscuro della trasformazione digitale in India

- AI e sanità in Usa

- Altman e OpenAI

- AI e open source

- AI e il rischio spionaggio

- Violazione dati utenti 23andMe

- No privacy al college

- Voto elettronico, food delivery e altro

EBOOK AI

Scarica gratis il nostro ebook Generazione AI

Il nostro ebook a più firme Generazione AI è scaricabile per tutti da qua. Da quando, tre giorni fa, lo abbiamo reso disponibile (come epub, mobi o pdf) sul nostro sito è stato scaricato un migliaio di volte.

Non solo è gratuito ma non chiediamo neanche una mail per fare il download, si va sulla pagina del nostro sito, si clicca e questo è quanto.

Ricordo che l’ebook è uscito il 4 settembre, quindi alcuni riferimenti (specie agli strumenti di AI, alle capacità e altri dettagli tecnici, oltre al fatto che l’AI Act è infine passato negli ultimi due giorni) sono da aggiornare, tenetene conto quando lo leggete. Ma il quadro sui temi e le questioni in gioco c’è ancora tutto. Anche perché l'ebook vuole soprattutto aprire verticali di approfondimento su vari aspetti economici, politici, culturali e conflittuali, come da linea editoriale di Guerre di Rete.

L’ebook è disponibile dall’inizio di settembre 2023 solo per gli 𝗘𝗱𝗶𝘁𝗼𝗿𝗶 𝗱𝗶 𝗥𝗲𝘁𝗲, cioè per 𝗶 𝗻𝗼𝘀𝘁𝗿𝗶 𝘀𝗼𝘀𝘁𝗲𝗻𝗶𝘁𝗼𝗿𝗶 che hanno partecipato alla campagna di crowdfunding di aprile. Tuttavia, poiché questo è 𝘂𝗻 𝗽𝗿𝗼𝗴𝗲𝘁𝘁𝗼 𝗻𝗼 𝗽𝗿𝗼𝗳𝗶𝘁 il cui obiettivo è fare informazione su temi digitali cruciali per il futuro di noi tutti, abbiamo deciso di condividere l’ebook con tutti i nostri lettori. Consideratelo il nostro regalo di Natale!

Da questa pagina del nostro sito potete scaricare l’ebook in vari formati.

ECCE AI ACT

Accordo sul regolamento sull’AI in Ue

Dopo più di due anni di gestazione, un record di 36 ore di negoziazioni estenuanti, una conferenza stampa annunciata e saltata a data da destinarsi, per poi finire in corner a mezzanotte, e un interesse da evento sportivo mai visto prima per regolamentazioni tech, è stato infine raggiunto un accordo politico in Europa per l’AI Act, il regolamento Ue sull’intelligenza artificiale.

L’accordo uscito dal trilogo (negoziazioni tra Parlamento, Consiglio e Commissione) in questo momento manca ancora di un testo definitivo a disposizione del pubblico, e molto si giocherà sui dettagli. Per questo motivo anche chi sosteneva la regolamentazione, specie la bozza più attenta alla difesa dei diritti uscita dal Parlamento a giugno, in questo momento sta sospendendo il giudizio in attesa di capire quanto i dettagli daranno margine di manovra agli Stati, alle eccezioni previste, e quanto alla difesa di quei diritti. Senza contare che molti aspetti tecnici saranno messi a terra nelle prossime settimane.

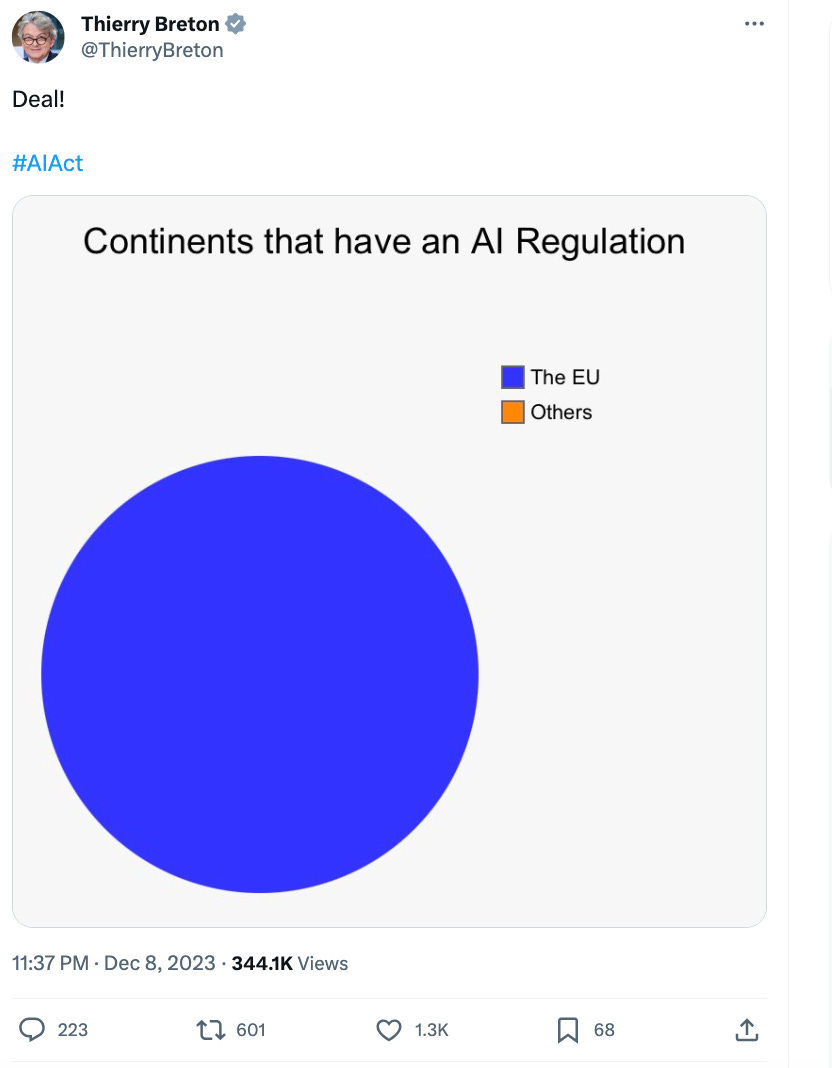

Ma intanto possiamo dire che già il fatto di aver trovato un accordo politico e aver chiuso l’AI Act è di per sé un successo, considerata la quantità di soggetti e interessi che remavano contro e quanti scommettevano, anche nelle ultime ore di trattative, sul fallimento delle stesse. Addirittura un euforico e poco diplomatico Thierry Breton, commissario al Mercato interno e gran cerimoniere delle negoziazioni e della conferenza stampa, è arrivato a dire che c’è stato molto lobbying contro e molti Stati “hanno cercato di fermarci” (notevole anche il suo tweet con il grafico dei continenti che hanno una legge sull’AI e quelli che non ce l’hanno).

Ad ogni modo, il tema è complesso, e mancano molte tessere del puzzle ancora, per cui da qui in avanti cercherò di fare una mia estrema sintesi basata sui documenti pubblici usciti, sulla conferenza stampa, e su altri resoconti pubblici (fonti linkate alla fine).

Le proibizioni

Proibite le seguenti applicazioni di AI:

- sistemi di categorizzazione biometrica che utilizzano caratteristiche sensibili (ad esempio, convinzioni politiche, religiose, filosofiche, orientamento sessuale, razza);

- lo scraping non mirato di immagini di visi da Internet o da filmati di telecamere a circuito chiuso per creare database di riconoscimento facciale (alla Clearview per intenderci)

- riconoscimento delle emozioni sul posto di lavoro e nelle istituzioni scolastiche (ma alcune eccezioni in nome della sicurezza, ad esempio per rilevare se un guidatore si sta addormentando)

- la classificazione sociale basata sul comportamento sociale o sulle caratteristiche personali (si tratta del cosiddetto social scoring)

- sistemi di AI che manipolano il comportamento umano per eludere la libera volontà delle persone

- AI utilizzata per sfruttare le vulnerabilità delle persone (a causa della loro età, disabilità, situazione sociale ecc)

Malgrado non sia nella lista del comunicato, anche il predictive policing (polizia predittiva) sarebbe stato proibito, quanto meno nella forma in cui si valuta il rischio che un certo individuo possa commettere reati futuri sulla base di tratti personali (qui cito Luca Bertuzzi, giornalista di Euractiv che ha fatto un gran lavoro nel seguire le negoziazioni). Tuttavia non è chiaro quale sia la formulazione precisa finale e quali siano i confini tecnici di questo ban.

Il corelatore dell’AI Act Dragos Tudorache (Renew, Romania) ha detto che sarebbe consentito in alcune circostanze. Di fronte a una domanda al riguardo, l’altro corelatore Brando Benifei (Socialisti e Democratici, Italia) ha detto (in inglese, traduco io dalla conferenza stampa) invece che c’è un “ban su tutte le attività di polizia predittiva, ma abbiamo concesso la possibilità di utilizzare applicazioni di analisi del crimine che non si applicano a singoli individui, bensì a tendenze anonime, ed escludiamo che possano prevedere o suggerire che qualcuno possa commettere un crimine. Abbiamo combattuto una buona battaglia e siamo convinti di essere dalla parte giusta”. A quel punto Tudorache ha riconosciuto che sì sono state vietate tutte le tecnologie che potrebbero predeterminare chi potrebbe commettere un crimine.

Il nodo del riconoscimento facciale in spazi aperti al pubblicoA causa delle pressioni dei governi sul Parlamento, non c’è un ban totale sui sistemi di identificazione biometrica da remoto (Remote Biometric Identification o RBI) in spazi accessibili al pubblico, nel senso che ci sono eccezioni a fini di applicazione della legge, previa autorizzazione giudiziaria e “per liste di reati rigorosamente definite”.

L'RBI da remoto ex-post (cioè non in tempo reale) verrebbe utilizzato esclusivamente per la ricerca mirata di una persona condannata o sospettata di aver commesso un reato grave (recita il comunicato).

L'RBI "in tempo reale" dovrebbe seguire condizioni rigorose e il suo uso sarebbe limitato nel tempo e nel luogo, ai fini di:

-ricerche mirate di vittime (rapimento, traffico, sfruttamento sessuale)

- prevenzione di una minaccia terroristica specifica e attuale

- localizzazione o identificazione di una persona sospettata di aver commesso uno dei reati specifici menzionati nel regolamento (ad esempio, terrorismo, traffico di esseri umani, sfruttamento sessuale, omicidio, rapimento, stupro, rapina a mano armata, partecipazione a un'organizzazione criminale, reati ambientali).

AI generativa e modelli di baseÈ stato concordato che i sistemi di AI per uso generale (GPAI), che possono svolgere compiti vari, dovranno aderire ai requisiti di trasparenza inizialmente proposti dal Parlamento. Questi includono la stesura di documentazione tecnica, il rispetto della legge sul copyright dell'Ue e la diffusione di sintesi dettagliate sui contenuti utilizzati per l’addestramento, recita il comunicato.

Per i modelli GPAI ad alto impatto con rischio sistemico, i negoziatori del Parlamento sono riusciti a ottenere obblighi più stringenti. Se questi modelli soddisfano determinati criteri (notate che questi criteri in parte sono ancora da definirsi e potranno essere aggiornati), dovranno condurre valutazioni del modello, dei rischi sistemici, test di sicurezza e riferire alla Commissione su incidenti gravi. Secondo le valutazioni di alcuni esperti, al momento solo GPT4 (e forse Gemini) ricadrebbero in questo livello di GPAI ad alto impatto. Mentre i prodotti di Mistral AI (la società francese di cui abbiamo scritto su Guerre di Rete) anche qualora vengano commercializzati, ricadranno nel livello più basso, non quello ad alto impatto (è stato detto in conferenza stampa in risposta a domanda).

Ci sono eccezioni per i modelli open source e per la ricerca, è stato detto in conferenza stampa. E ci sono ambienti regolatori (sandbox) ad hoc per le piccole e medie imprese per poter innovare più agevolmente.

Tempistiche e sanzioni

Sei mesi per le proibizioni. 12 mesi per i requisiti di trasparenza e governance. 24 mesi per il resto. Nel mentre prevista anche una fase di transizione chiamata AI Pact di volontaria adesione delle aziende.

“Il mancato rispetto delle norme può portare a multe che vanno da 35 milioni di euro o il 7% del fatturato globale a 7,5 milioni o l'1,5% del fatturato, a seconda della violazione e delle dimensioni dell'azienda” (comunicato).

Per dirla con uno scoppiettante Breton: “No penalties, no regulation”.

Fonti: comunicato stampa Parlamento Ue; conferenza stampa (video); comunicato Commissione; Consiglio; AI Pact; Euractiv.

Ne hanno scritto anche: Wired Italia; NYT; WashPost; ReutersCIFRATURA

Messenger cifrato

Meta ha introdotto la crittografia end-to-end (la più sicura) di default per i messaggi e le chiamate personali su Messenger e Facebook.

La parola chiave qua è di default, cioè non si tratta di un’opzione da scegliere da parte degli utenti, è predefinita in questo modo. Infatti, dal 2016 Messenger offriva già la possibilità di attivare la crittografia end-to-end (nelle Chat Segrete), ma doveva essere scelta dagli utenti. “Ci sono voluti anni per ottenere questo risultato, perché ci siamo presi tutto il tempo necessario per farlo bene”, scrive Meta - e per gestire la pressione di quei governi che non volevano questa estensione, aggiungo io.

La decisione è stata salutata con soddisfazione da attivisti per la privacy e i diritti digitali come Fight for the Future.

Da ora in poi, e in tutti i casi, neanche Meta potrà leggere i contenuti delle chat su Messenger (o renderli disponibili a quei governi che glieli chiedano). E saranno presenti anche i Messaggi a scomparsa.

Come è meglio evidenziato in un blog post più tecnico di Meta, la crittografia end-to-end predefinita per ora è “per i messaggi personali one-to-one su Messenger, siamo ancora in fase di test per la messaggistica di gruppo e per alcuni altri prodotti, come i messaggi diretti di Instagram”.

Il blog post è anche interessante perché cerca di fornire elementi di trasparenza e di fiducia sul fatto che Meta implementi questa tecnologia in modo sicuro e affidabile.

Plausi dal crittografo Matthew Green.

GOOGLE / GEMINI

“What the quack”

Google ha annunciato il lancio di Gemini, il suo ultimo e più avanzato modello linguistico di grandi dimensioni. Il chatbot Bard dell'azienda sarà dunque alimentato da una versione di Gemini mentre gli sviluppatori e i clienti aziendali avranno accesso a Gemini tramite API nei prossimi giorni. Infine, una versione più avanzata sarà disponibile l'anno prossimo.

Gemini è un modello multimodale, il che significa che può analizzare il contenuto di un'immagine e rispondere a domande sulla stessa, oppure crearne una a partire da un prompt (The Platformer).

Google ha anche rilasciato un video per illustrare le capacità di Gemini, anche se da contenuti di questo genere resta sempre difficile, se non impossibile, valutare le interazioni reali e confrontare i modelli (qua il video su YouTube).

Per altro Google ha poi ammesso che la dimostrazione video non è avvenuta in tempo reale con messaggi vocali (come sembrerebbe nel video editato), ma ha utilizzato fotogrammi di immagini e messaggi di testo ai quali Gemini ha risposto. "Questo è molto diverso da ciò che Google sembrava suggerire - scrive la giornalista Parmy Olson su Bloomberg - cioè che una persona potesse avere una conversazione vocale fluida con Gemini mentre questo osservava e rispondeva in tempo reale al mondo circostante".

Vedi anche The Verge e The Information.

DIRITTI DIGITALI

Il lato oscuro della trasformazione digitale in India

Tra gli attivisti e gli esponenti dell’opposizione indiana è scattato un campanello d’allarme: in molti sospettano, e non senza le loro ragioni, che dietro la possibile compromissione dei loro dispositivi ci sia il governo nazionale, guidato dal partito del primo ministro Narendra Modi.

Dagli spyware alle minacce alla crittografia, dalle leggi repressive sui media alla censura, il laboratorio indiano interroga anche l’Europa. E le tentazioni autoritarie delle democrazie. Il nostro articolo su Guerre di Rete firmato da Irene Doda.

OPENAI

Gli interessi di Altman

Durante il mandato di Sam Altman come CEO, OpenAI aveva firmato una lettera d'intenti per spendere 51 milioni di dollari in chip AI di una startup chiamata Rain AI, società in cui lo stesso Altman ha investito personalmente, riferisce Wired Usa. Rain ha dichiarato agli investitori che Altman avrebbe investito personalmente più di un milione di dollari nell'azienda.

“La lettera di intenti di OpenAI con Rain mostra come la rete di investimenti personali di Altman possa intrecciarsi con i suoi compiti di CEO di OpenAI. La sua precedente posizione alla guida dell'incubatore di startup Y Combinator ha aiutato Altman a diventare uno dei più importanti dealmaker della Silicon Valley, investendo in decine di startup e facendo da intermediario tra gli imprenditori e le più grandi aziende del mondo”.

Ma proprio questa sua “distrazione” e la commistione delle sue molteplici attività avrebbero avuto un ruolo nel suo clamoroso licenziamento (poi rientrato) da parte del consiglio di amministrazione di OpenAI per comunicazioni non sincere.

AI E SANITA’

Biden vuole trasparenza sulle applicazioni AI usate in sanità

È stato riscontrato che alcune tecnologie di AI usate per prendere note da parte dei medici potevano produrre errori nei rapporti, non utilizzavano la terminologia corretta e in alcuni casi aggiungevano farmaci che il paziente non stava assumendo. (La parte più interessante di questa storia, uscita qualche mese fa, è che gli sviluppatori di queste app avevano dovuto mettere in piedi un team di 200 contractor incaricati di ascoltare le conversazioni e rivedere le note, nell’ennesima evoluzione della metafora del Turco Meccanico).

Ma gli strumenti di AI applicati alla sanità possono anche fare previsioni errate influenzate dall’origine del paziente o dal suo livello di reddito (come avvenuto in passato negli Usa).

È in questo scenario che le autorità di regolamentazione federali Usa stanno proponendo un nuovo sistema di etichettatura per le app sanitarie di intelligenza artificiale, volto a rendere più facile per i medici la possibilità di individuare eventuali insidie e carenze degli stessi strumenti.

L'amministrazione Biden ha proposto che queste app siano dotate di una etichetta informativa che illustri come l'app è stata addestrata, come si comporta, come dovrebbe essere usata e come non dovrebbe.

“La norma sull'etichettatura, che potrebbe essere finalizzata entro la fine dell'anno, rappresenta uno dei primi tentativi concreti di Washington di imporre nuovi requisiti di sicurezza all'intelligenza artificiale. Le aziende sanitarie e tecnologiche si oppongono, affermando che la norma potrebbe compromettere le informazioni proprietarie e danneggiare la concorrenza”, scrive il WSJ.

OPEN SOURCE

L’AI open source si allea e si fa sentire

Il 5 dicembre è stata lanciata una nuova alleanza globale per lo sviluppo open source dell'AI. “È un attacco contro i produttori di modelli chiusi di AI (OpenAI, Google e Anthropic) che hanno dominato gran parte della conversazione nel 2023 e che l'alleanza ritiene stiano creando distrazioni dai rischi immediati dell'AI”, scrive Axios.

Più di 50 organizzazioni, guidate da Meta e IBM, hanno aderito all'Alleanza per l'AI, tra cui Intel, Oracle, Dell, AMD, Sony, Hugging Face e Stability AI, ma anche la NASA e il CERN, più una serie di università. E si sono impegnate a lavorare su modelli di base aperti, "compresi modelli multilingue, multimodali e scientifici" che affrontino sfide come il cambiamento climatico e le diseguaglianze educative.

(Anche se, come ho scritto altre volte da queste parti, la stessa definizione di AI open source è dibattuta e alcuni dei modelli definiti open sono criticati per non esserlo abbastanza).

AI

AI e spionaggio di massa

Lo spionaggio è sempre stato limitato dalla necessità di manodopera umana. Ma ora l'intelligenza artificiale sta per cambiare le cose. Stiamo per entrare nell'era dello spionaggio di massa. Così argomenta uno dei più noti studiosi di crittografia e sicurezza informatica, Bruce Schneier. Questo perché, sostiene, “la sintesi è un'attività che un moderno sistema di intelligenza artificiale generativa svolge egregiamente. Se gli date una riunione di un'ora, vi restituirà un riassunto di una pagina di ciò che è stato detto. Chiedetegli di cercare tra milioni di conversazioni e di organizzarle per argomento, e lo farà. Volete sapere chi sta parlando di cosa? Ve lo dirà. (...) A differenza degli esseri umani, gli strumenti di AI possono essere replicati a milioni e stanno migliorando a ritmi sorprendenti. Miglioreranno l'anno prossimo e ancora di più l'anno successivo”.

Prima avevamo già assistito alla sorveglianza di massa, che però si alimentava più di dati, metadati e parole chiave. Qua si entra nel reame dei contenuti più dettagliati.

“Lo spionaggio di massa cambierà la natura dello spionaggio. Tutti i dati saranno salvati. Saranno tutti ricercabili e comprensibili, in blocco. Dimmi chi ha parlato di un particolare argomento nell'ultimo mese e come si sono evolute le discussioni su quell'argomento. La persona A ha fatto qualcosa; verificare se qualcuno le ha detto di farlo. Trovate tutti coloro che stanno organizzando un crimine, o diffondendo una voce, o pianificando di partecipare a una protesta politica”.

Di tutti gli impatti dell’AI generativa questo è stato in effetti finora il meno esplorato.

CYBER

Dati esposti per quasi 7 milioni di clienti 23andMe

La nota società di test genetici 23andMe ha riferito che dei cybercriminali sono riusciti a violare i dati di 6,9 milioni di loro clienti (quasi la metà dei 14 milioni complessivi). 23andMe ha dichiarato che la violazione dei dati è stata causata dal riutilizzo delle password da parte degli utenti, che ha permesso ai cybercriminali di fare un attacco brute force sugli account delle vittime utilizzando password estratte da violazioni di altre aziende. Ma a causa del modo in cui è strutturata una funzione opt-in nota come DNA Relatives, che abbina gli utenti ai loro parenti, gli attaccanti sono riusciti, entrando in account individuali, a vedere i dati personali non solo del titolare dell'account ma anche dei suoi parenti, “il che ha ampliato il numero totale delle vittime di 23andMe”, scrive TechCrunch.

LIBERTA’ DI RICERCA

Il J’accuse di una ricercatrice sulla disinformazione

Joan Donovan, nota studiosa delle campagne di disinformazione online, ha accusato la Kennedy School dell'università di Harvard di averle dato il benservito perché le sue ricerche avrebbero minacciato i legami finanziari dell’istituto con Meta.

Dal 2018 Donovan dirigeva un team di ricercatori su disinformazione ed estremismo. Ma in una dichiarazione di 120 pagine rilasciata nei giorni scorsi, la studiosa sostiene che i suoi capi avrebbero iniziato a rivoltarsi contro di lei alla fine del 2021, dopo che Donovan aveva pianificato la pubblicazione di una serie di documenti su Facebook (ora Meta). Proprio mentre quest’ultima si stava preparando a fare un'importante donazione ad Harvard. La Kennedy School ha respinto con forza le accuse definendole false.

Chronicle

STUDENTI E PRIVACY

No privacy al college

Poche istituzioni raccolgono così tanti dati sulle persone al loro interno come i college e le università negli Usa. I campus residenziali, in particolare, fanno sì che gli studenti interagiscano con le loro scuole non solo per gli studi, ma anche per l'alloggio, l'uso privato di internet, la ristorazione, l'assistenza sanitaria, le attività di fitness e la socializzazione. Tuttavia, che vivano nel campus o fuori, che seguano le lezioni di persona o a distanza, gli studenti non possono sottrarsi alla raccolta di questi dati. E non è sempre chiaro come saranno utilizzati. Inchiesta di The Markup

APPROFONDIMENTI

DEMOCRAZIA

Le istruzioni per la prima simulazione di voto elettronico in Italia

Le ha diffuse il Viminale in un tutorial per i cittadini all'estero che prenderanno parte alle prove generali di suffragio da remoto il 13 e 14 dicembre Wired Italia

FOOD DELIVERY

Privacy, dati personali e sicurezza: ecco come li usano le app di food delivery

Le procedure per iscriversi e per controllare l'identità dell'utente. Le politiche sulla privacy e sull'uso dei dati personali. Le app dei fattorini. Analisi delle piattaforme che consegnano cibo a domicilio - Wired Italia

AI

Sul consenso Bruxelles-Washington sulla definizione giuridica di Intelligenza Artificiale. Un paper di Luciano Floridi

→ DIFFONDI LA NEWSLETTER

Ti è piaciuta la newsletter? Inoltrala a chi potrebbe essere interessato! Promuovila sui social. La newsletter (che è fatta nel mio tempo libero) resta gratuita, indipendente, senza sponsor, mandanti o agende altrui, e si diffonde col passaparola dei suoi stessi utenti.

Non sei ancora iscritto? Iscriviti qua, è gratuita.

—> INFO SU GUERRE DI RETE

Guerre di Rete è un progetto di informazione sul punto di convergenza e di scontro tra cybersicurezza, sorveglianza, privacy, censura online, intelligenza artificiale, diritti umani, politica e lavoro. Nato nel 2018 come newsletter settimanale, oggi conta oltre 12.000 iscritti e da marzo 2022 ha aggiunto il sito GuerreDiRete.it.

Nell’editoriale di lancio del sito avevamo scritto dell’urgenza di fare informazione su questi temi. E di farla in una maniera specifica: approfondita e di qualità, precisa tecnicamente ma comprensibile a tutti, svincolata dal ciclo delle notizie a tamburo battente, capace di connettere i puntini, di muoversi su tempi, temi, formati non scontati.

Il progetto è del tutto no profit, completamente avulso da logiche commerciali e di profitto, e costruito sul volontariato del gruppo organizzatore (qui chi siamo). Non ha sponsor né pubblicità, né aziende o lobbies alle spalle.

Ha anche una pagina Facebook, un profilo Twitter, Linkedin e Instagram. Seguiteli! I podcast della newsletter li trovate sulle principali piattaforme ma attualmente sono in pausa (Apple Podcasts; Spotify; Google Podcast; Anchor.fm)

如有侵权请联系:admin#unsafe.sh