原文标题: Machine Unlearning via Representation Forgetting With Parameter Self-Sharing原文作者: Weiqi Wang, 2023-11-13 17:18:13 Author: 安全学术圈(查看原文) 阅读量:13 收藏

原文标题: Machine Unlearning via Representation Forgetting With Parameter Self-Sharing

原文作者: Weiqi Wang, Chenhan Zhang, Zhiyi Tian, Shui Yu

发表期刊: IEEE Transactions on Information Forensics and Security

原文链接: https://ieeexplore.ieee.org/document/10312776

主题归类: 机器学习模型隐私

笔记作者: Weiqi Wang

"Machine unlearning"旨在设计一种方法允许数据所有者可以将他们指定的数据贡献从已经训练好的模型中删除。但是,现有的方法难以在移除效果和模型效用维持中找到一个最优平衡。这是因为此前的相关工作全部的注意力都集中在研究如何设计方法来最大化地从模型中移除用户指定的数据的贡献。因此这些方法也常常导致模型效用的降低,又常称为灾难性遗忘。

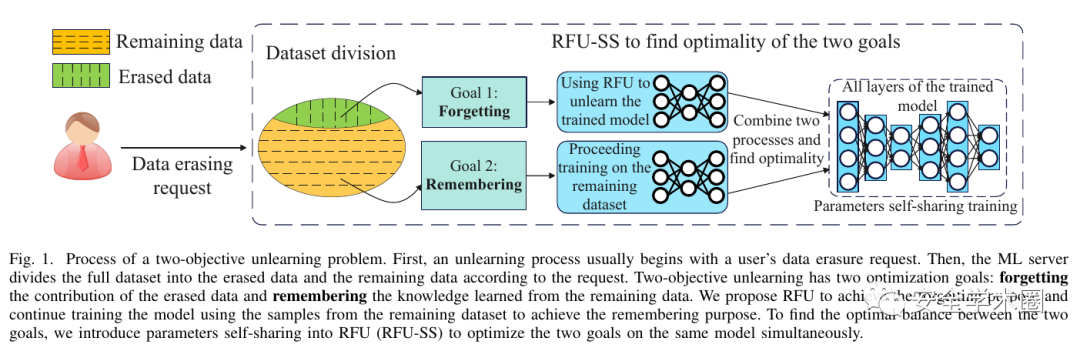

为了解决"Machine unlearning"中这种灾难性遗忘的问题,本文系统化地考虑"Machine unlearning"问题,并且将它形式化为一个双目标优化的问题,包含待删除数据的遗忘和已学习知识的保留。我们提出了RFU-SS的方法来解决这双目标优化的unlearning问题。RFU-SS包含两个主要的贡献。首先,我们提出“Representation-Forgetting Unlearning (RFU)"来解决第一个目标:待删除数据的遗忘。第二个目标已学习知识的保留则可以通过将被遗忘的模型在剩余数据集上重训练达成。然后,为了同时获得这两个目标的最优解,我们定制了参数自共享的优化方法,即RFU-SS。下图即为本文方法的主要流程图。

我们参数自共享的灵感来源于多任务学习中的hard参数共享的研究。不同的是,虽然在我们定义好的双目标unlearning问题中存在两个优化目标,但是我们的两个目标并不需要额外的任务层。因此RFU-SS可以直接共享全部的参数来求解双目标的Pareto最优。也因此我们称次方法为参数自共享。模型自共享参数训练的过程如下图所示。详细的算法请参考文章中的算法1。

图7展示了我们的方法对于unlearning中的双目标的优化结果。对比的state-of-the-art方法通常只能取得单目标的最优而很难同时获得双目标的最优。我们的RFU-SS方法则可以同时达成双目标的最优化。

本文解决了“machine unlearning”中的灾难性遗忘问题。我们首先将unlearning的问题形式成一个双目标优化的问题,包含数据移除和效用保留。然后我们提出了RFU的遗忘方案,并设计出参数自共享的方法来获得双目标的Pareto最优。大量的分析和实验都验证了提出方法的有效性和优越性。

在未来,基于本文依然可以做许多有趣的工作。我们从unlearning问题定义的层面阐明了“machine unlearning”应该包含两个优化目标。这种新的理解和我们设计的解决思路可以帮助改进之前的方案来缓解灾难性遗忘的问题。另外,我们也畅想我们的方法可以应用到unlearning以外的方法中去,比如在life-long learning中帮助遗忘噪声和异常数据以保证模型的效用。

王卫其,悉尼科技大学博士生,主要研究方法是机器学习的安全与隐私。https://scholar.google.com/citations?user=r0O_bbAAAAAJ

安全学术圈招募队友-ing

有兴趣加入学术圈的请联系 secdr#qq.com

如有侵权请联系:admin#unsafe.sh