早前蓝点网提到英伟达推出专用加速卡NVIDIA H100,该加速卡是前代加速卡A100性能的3倍价格也是3倍。

趁着AI热潮黄仁勋显然再次抓住热点:英伟达今天宣布推出针对LLM大型语言模型的专用加速卡H100 NVL。

推出这个新SKU是因为英伟达注意到LLM运行时,超大量的数据会迅速填充显存,普通版本已经跟不上使用。

所以NVIDIA H100 NVL是迄今为止显存容量最大的版本,显存为188GB HBM3 显存,单卡显存容量94GB。

专门为LLM设计的新版本:

英伟达在新闻稿中表示 NVIDIA H100 加速卡已经全面投产,很快英伟达和合作伙伴将向全球企业推出新卡。

H100加速卡在LLM上提供快9倍的AI训练以及快30倍的AI推理 , 为全球AI企业发挥创造力提供强大动力基础。

不过今天还有个重点就是H100 NVL版 , 这是英伟达专门面向大型语言模型推出的新SKU主要就是超大显存。

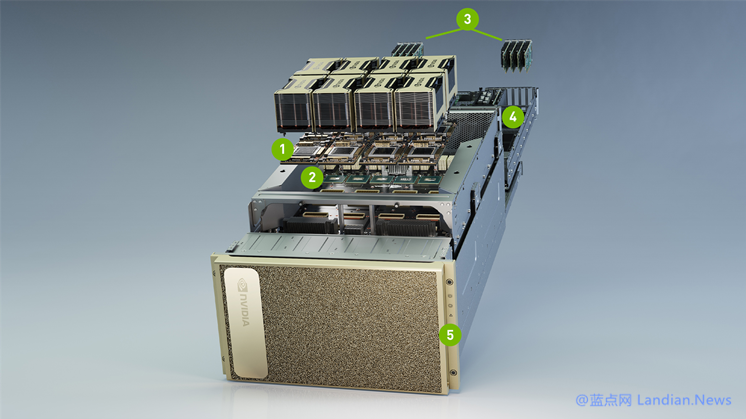

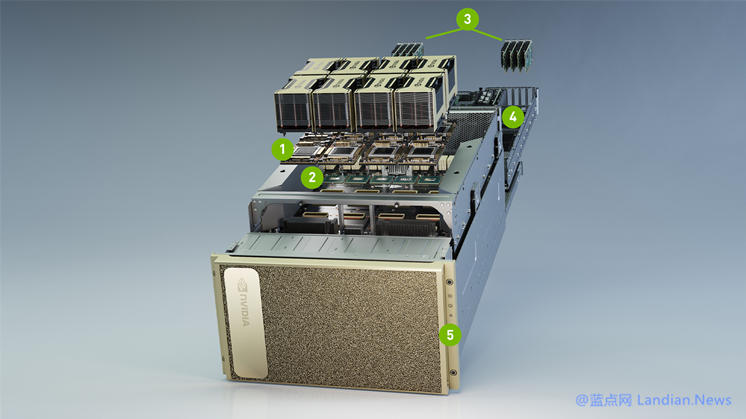

H100 NVL实际上是2张H100合并后的结果 , 主要通过PCIe板进行桥接,每张卡显存为94GB合计为188GB。

连插槽都是2个PCIe 5.0的因此普通主板都插不上,估计要购买 H100 NVL 的话也得顺带购买配套专用主板。

具体价格方面目前还不清楚,此前传闻H100售价 32000 美元约合人民币22万元,H100 NVL也必然会翻倍。

以下是H100三种SKU参数对比:

| NVIDIA H100 Accelerator Specification Comparison | |||||

| H100 NVL | H100 PCIe | H100 SXM | |||

| FP32 CUDA Cores | 2 x 16896? | 14592 | 16896 | ||

| Tensor Cores | 2 x 528? | 456 | 528 | ||

| Boost Clock | 1.98GHz? | 1.75GHz | 1.98GHz | ||

| Memory Clock | ~5.1Gbps HBM3 | 3.2Gbps HBM2e | 5.23Gbps HBM3 | ||

| Memory Bus Width | 6144-bit | 5120-bit | 5120-bit | ||

| Memory Bandwidth | 2 x 3.9TB/sec | 2TB/sec | 3.35TB/sec | ||

| VRAM | 2 x 94GB (188GB) | 80GB | 80GB | ||

| FP32 Vector | 2 x 67 TFLOPS? | 51 TFLOPS | 67 TFLOPS | ||

| FP64 Vector | 2 x 34 TFLOPS? | 26 TFLOPS | 34 TFLOPS | ||

| INT8 Tensor | 2 x 1980 TOPS | 1513 TOPS | 1980 TOPS | ||

| FP16 Tensor | 2 x 990 TFLOPS | 756 TFLOPS | 990 TFLOPS | ||

| TF32 Tensor | 2 x 495 TFLOPS | 378 TFLOPS | 495 TFLOPS | ||

| FP64 Tensor | 2 x 67 TFLOPS? | 51 TFLOPS | 67 TFLOPS | ||

| Interconnect | NVLink 4 18 Links (900GB/sec) | NVLink 4 (600GB/sec) | NVLink 4 18 Links (900GB/sec) | ||

| GPU | 2 x GH100 (814mm2) | GH100 (814mm2) | GH100 (814mm2) | ||

| Transistor Count | 2 x 80B | 80B | 80B | ||

| TDP | 700W | 350W | 700-800W | ||

| Manufacturing Process | TSMC 4N | TSMC 4N | TSMC 4N | ||

| Interface | 2 x PCIe 5.0 (Quad Slot) | PCIe 5.0 (Dual Slot) | SXM5 | ||

| Architecture | Hopper | Hopper | Hopper | ||

版权声明:感谢您的阅读,本文由山外的鸭子哥转载或编译自Anandtech,如需转载本文请联系原作者获取授权,谢谢理解。