在挖SRC漏洞时,我们通常会从信息收集开始,挖掘企业主域名、子域名、端口扫描、网站爬虫等一系列操作,做完这些操作之后,你会发现花费了大量的时间和精力,那么有没有什么办法,快速发现目标相关带参数的链接,直接开始漏洞扫描呢?

在挖SRC漏洞时,我们通常会从信息收集开始,挖掘企业主域名、子域名、端口扫描、网站爬虫等一系列操作,做完这些操作之后,你会发现花费了大量的时间和精力,那么有没有什么办法,快速发现目标相关带参数的链接,直接开始漏洞扫描呢?

老外这块做的多,在网络上部署大量节点对全网网站进行爬取,保存目标相关的链接,待用户需要时,针对性的搜索即可,比如:

https://web.archive.org/

类似的平台还有其他的,当我们拿到一个项目的时候,不妨先试试这个,今天给大家分享一个工具 gau:

https://github.com/lc/gau

集成的 url 查询平台有四个,如图:

除了这个,还有一个加强版 gauplus:

https://github.com/bp0lr/gauplus

从名字上看是一个大号版的 gau,速度比 gau 快,如果针对大量目标的话,用 gauplus 是个不错的选择:

接下来安装尝试下 gauplus 的功能如何,安装比较简单,先部署好 go 环境,然后下载代码,go build 就可以,咱们以 xazlsec.com 为例,看看能搜到些啥:

echo xazlsec.com | ./gauplus -o xazlsec.txt

结果是目标相关的所有链接,包含图片、js 文件等,但是没有发现 edu、wiki 这几个域名之下的内容,说明该数据集并不全面,但是作为挖洞起始的数据已经可以了,剩下的资产数据可以自己通过子域名枚举等方式获取。

那么有了这些数据有啥用呢?说实话,用处非常大,下面给大家分享几个思路:

1、编辑器漏洞发现

看图片的路径,是否存在比较知名的编辑器,比如 ueditor、kineditor、fckeditor 等,如果存在那么就可以尝试有没有编辑器的漏洞,比如我提取路径中带有 ueditor 的网站,使用 xray 的 poc-yaml-ueditor-cnvd-2017-20077-file-upload 进行测试,扫描出的结果如图:

然后尝试复现,使用我自己编写的脚本。地址:

https://github.com/myh0st/scripts/blob/master/cnvd-2017-20077.py

在远程服务器上创建一个图片文件比如 1.png,然后启动 web 服务:

python3 -m http.server 8080

比如 url:https://111.111.11.11:8080/1.png

在 url 后面添加 ?.aspx ,比如

https://111.111.11.11:8080/1.png?.aspx

替换掉 poc 中的图片地址,然后就可以批量检测,上传成功之后,会返回数据包:

访问之后:

漏洞利用成功。

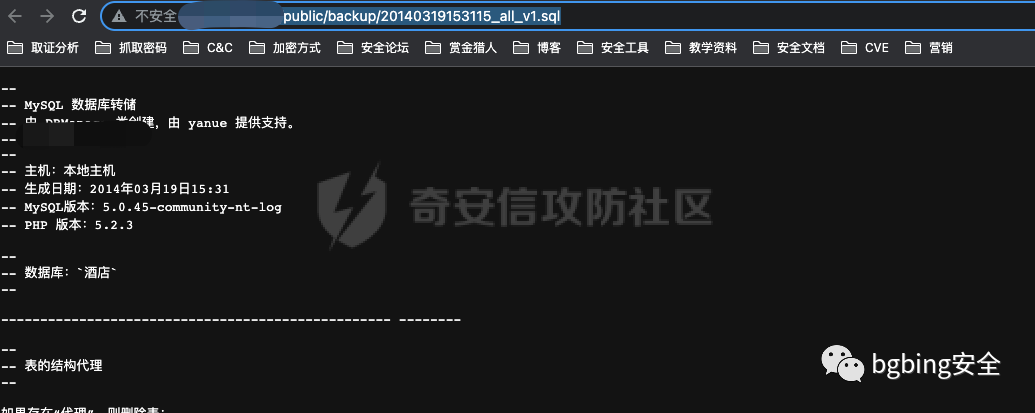

2、寻找备份文件

看关键词 .sql、.bak等后缀是否存在,如果存在说明找到了一些数据库备份、网站源码备份等

这种是因为目标存在列目录的问题,导致爬虫可以爬取到备份的文件路径,比如这种:

3、针对GET参数进行漏扫

提取带参数的 URL,比如 URL 包含关键词 ? 和 = 的,提取出来之后,进行去重,去重小工具,参考:

https://github.com/s0md3v/uro

效果如图:

去重之后就可以用 xray 批量检测,检测命令:

xray.exe webscan --uf urlfile.txt --ho output.html

漏洞还真不少,如图:

接下来就是一一验证了。

4、发现JS敏感信息

提取 js 文件,从 js 中提取关键信息,比如各种 token、api key 等,工具参考:

https://github.com/m4ll0k/SecretFinder

其原理是通过正则匹配常见敏感字符串,核心正则:

比如泄露企业微信的认证token:

5、抓取POST请求进行漏扫

可以借助爬虫 crawlergo 抓取POST请求及参数,然后将数据包发送给被动漏洞扫描器,比如 xray 来进行扩展漏扫,发现登录认证功能的漏洞。

crawlergo 的下载地址:

https://github.com/Qianlitp/crawlergo

基于 chrome 内核,触发 js 执行,自动表单填写,可以爬取链接的同时,抓取到 POST 请求及参数,其可以与 xray 联动,具体操作,这里就不细说了。

以上就是在不接触目标的情况下,获取目标相关信息,然后进行漏洞发现,当然漏洞发现必须要接触目标才行,在时间有限的情况下,这不失为一种非常好的渗透思路。

原文地址:https://forum.butian.net/share/1713热文推荐

如有侵权请联系:admin#unsafe.sh